Im Inneren eines KI-Computers: Warum moderne KI-Systeme so viel Speicher benötigen

Wie ein KI-Server wirklich aussieht, wenn man den Deckel öffnet

Derzeit gibt es viel Lärm darüber, dass KI „zu viel Speicher“ verbraucht. Die Preise steigen. Die Verfügbarkeit ist knapp. Überall heißt es, die Nachfrage explodiere. Das haben Sie wahrscheinlich schon gelesen.

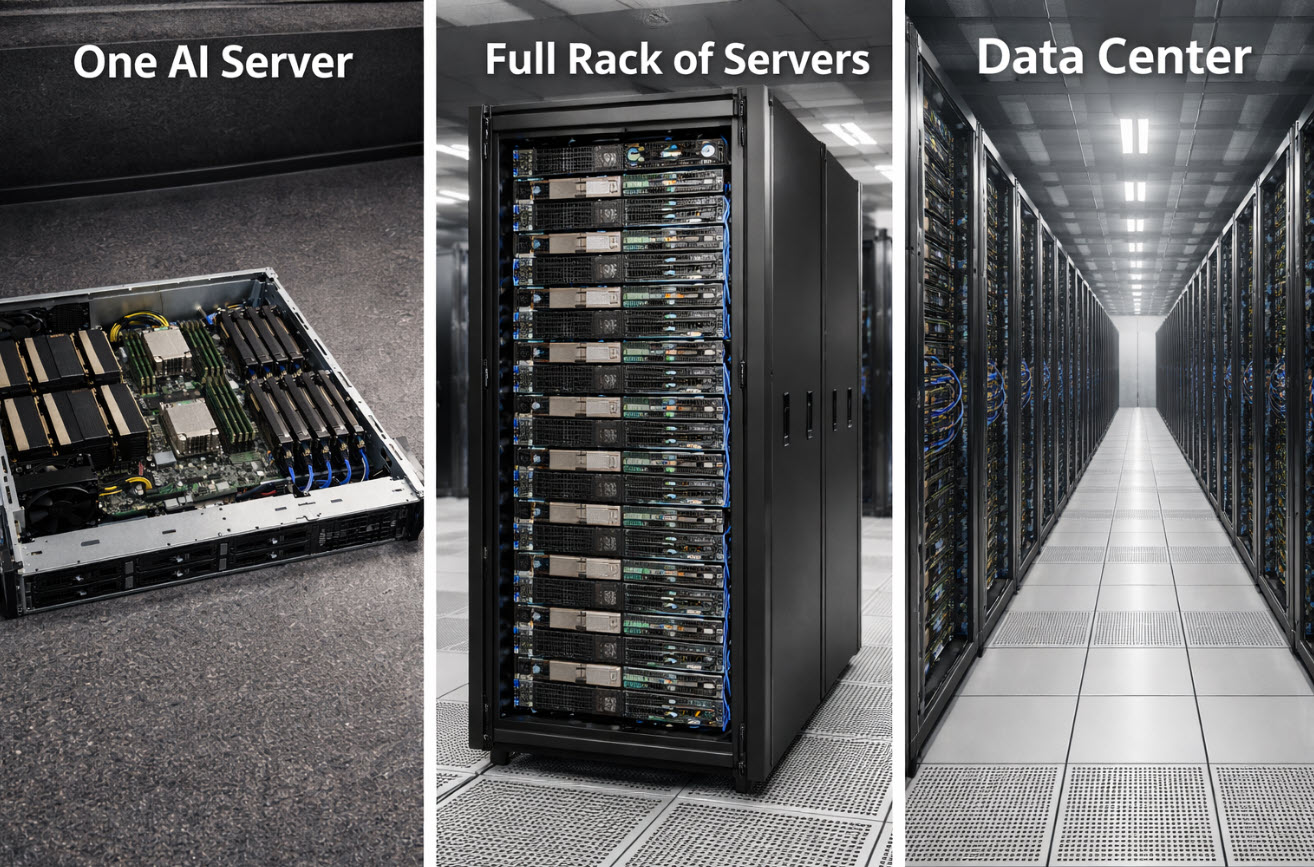

Doch das meiste, was darüber geschrieben wird, lässt den wichtigsten Punkt aus: wie ein KI-Computer physisch aussieht und warum er überhaupt so viel Speicher benötigt. Nicht in abstrakten Diagrammen oder Marktprognosen, sondern in Begriffen, die man sich vorstellen kann. Sobald man versteht, was ein einzelnes KI-System tatsächlich verbraucht, klingt der Rest der Geschichte nicht mehr dramatisch, sondern unvermeidlich.

Ich habe das kürzlich an einem Ort erklärt, der mit Rechenzentren nichts zu tun hat. Ich war an der Schule meines Kindes bei einem „Elterntag“, stand in einem Klassenzimmer, und ein paar Schülerinnen und Schüler begannen, Fragen zu KI zu stellen. Keine Chatbot-Fragen. Echte Fragen. Wie sieht der Computer aus? Wohin gehen die Daten? Warum reden alle ständig von „Speicher“, als wäre das der entscheidende Punkt?

Also habe ich klein angefangen. Ich habe sie gebeten, sich einen normalen Computer vorzustellen. Einen, den man zu Hause benutzen würde. Er hat einen Prozessor, der rechnet, einen Arbeitsspeicher, der festhält, womit gerade gearbeitet wird, und einen Speicherplatz, der Dinge für später aufbewahrt. Hausaufgaben. Fotos. Spiele. Alles hat seinen Platz.

Dann habe ich erklärt, dass KI immer noch ein Computer ist – aber keiner, der nur eine kleine Aufgabe nach der anderen erledigt. Er führt riesige Mengen an Berechnungen über riesige Datenmengen aus, immer wieder, vergleicht Muster, passt Gewichtungen an, speichert Zwischenstände und tut das alles so schnell, dass langsamer Speicher zum größten Feind wird.

Deshalb wird Speicher zum Star der Show. Nicht, weil er gerade im Trend liegt. Sondern weil die GPUs ohne genügend Speicher und schnellen Zugriff einfach warten würden – und das ist, als würde man einen Rennwagen kaufen und ihn stehen lassen, weil die Straße zu schmal ist.

Ein KI-Server ist kein einzelner Desktop-Tower. Er ähnelt eher einer extrem dicht gepackten Workstation auf Steroiden. Ein typischer Trainingsserver heute hat acht GPUs, und jede GPU verfügt über ihren eigenen ultraschnellen Speicher, nur um mit der Rechenlast Schritt zu halten. Darüber hinaus besitzt der Server einen großen Pool an Systemspeicher, um die GPUs ohne Engpässe zu versorgen, sowie eine ganze Reihe von NVMe-SSDs im Gehäuse, um Datensätze zwischenzuspeichern und Zwischenergebnisse zu schreiben.

Wenn man eine echte Stückliste für eine solche Maschine sieht, ist das nicht subtil. Man blickt auf Hunderte Gigabyte GPU-Speicher, oft ein halbes Terabyte bis mehrere Terabyte Systemspeicher, und auf zig Terabyte NVMe-SSD-Speicher in einem einzigen Server. Nicht im Netzwerk. Nicht in einem gemeinsamen SAN. In einer Box.

Das ist meist der Moment, in dem es still wird, weil das Ausmaß plötzlich greifbar ist. Ein einzelner Server kann mehr Flash-Speicher enthalten, als die meisten Haushalte jemals besitzen werden. Und KI skaliert nicht, indem man einen Server hinzufügt und Schluss macht. Sie skaliert, indem man Dutzende oder Hunderte auf einmal hinzufügt – denn das Training großer Modelle ist Mannschaftssport. Eine einzelne Maschine trägt die Last nicht allein.

Wenn also ein einzelner KI-Server unauffällig zwanzig oder dreißig Terabyte Flash-Speicher verbraucht, was passiert dann, wenn man hundert davon einsetzt? Plötzlich spricht man von Petabytes an NAND-Flash, die in einem einzigen Ausbau verschlungen werden – und das noch bevor man gemeinsam genutzte Speichersysteme, Replikation, Backups, Protokollierung und die „wir brauchen es schneller als im letzten Quartal“-Upgrades berücksichtigt, die beginnen, sobald das Cluster produktiv ist.

An diesem Punkt hören die Geschichten über Speichermangel auf, nach Hype zu klingen, und beginnen, wie einfache Mathematik zu wirken. Speicherfabriken entstehen nicht über Nacht. Flash und DRAM benötigen Jahre für Planung, Bau, Qualifizierung und Hochlauf. Selbst wenn Schlagzeilen über schwankende Speicherpreise erscheinen, verschwinden die zugrunde liegenden Angebotsgrenzen nicht, wenn die Nachfrage in Rechenzentrumsgröße eintrifft.

Und dann kommt die zweite Welle: Rack-Skalensysteme. Statt jeden Server als eigenständige Maschine zu betrachten, bauen Hersteller heute ganze Racks, die sich wie ein einzelner Computer verhalten. Dutzende GPUs in einem Rack, riesige Speicherpools, Reihen von SSDs dicht an dicht. Abstände werden in Zentimetern gemessen, nicht in Metern, weil Geschwindigkeit so entscheidend ist.

Ab diesem Punkt fragt man nicht mehr: „Wie viel Speicher braucht ein Computer?“ Man fragt: „Wie viel Speicher braucht ein Rack?“ Und genau deshalb spüren Unterhaltungselektronikprodukte den Druck. Nicht, weil Verbraucher plötzlich doppelt so viele Smartphones kaufen, sondern weil ein anderer Käufer mit einer ganz anderen Größenordnung aufgetaucht ist – und dieser kauft in Blöcken, die wie ganze Rechenzentren aussehen.

Auf der Speicherebene erklärt das auch, warum langjährige Annahmen über das Verhalten von Flash-Speicher ins Wanken geraten. Wenn KI-Workloads die Nachfrage dominieren, hören Unterscheidungen wie MLC versus TLC NAND auf, rein akademisch zu sein, und beginnen, Verfügbarkeit, Lebensdauer und Zuteilungsentscheidungen ganz konkret zu beeinflussen.

Die Kinder brauchten keinen Vortrag über Lieferketten, um das zu verstehen. Sie brauchten nur das Bild. Eine Box wird zu einer Reihe. Eine Reihe wird zu einem Rack. Ein Rack wird zu einem Raum. Ein Raum wird zu einem Gebäude. Sobald man KI als Infrastruktur sieht und nicht als Magie, wird die Speicherfrage physisch, mechanisch und vorhersehbar.

Und genau darum geht es. Das ist kein rätselhafter Mangel. Es ist eine vorhersehbare Kollision zwischen Kapazitäten, deren Aufbau Jahre dauert, und einer Nachfrage, die über Nacht in Form von ein paar LKW-Ladungen Servern vor einem lagerhallengroßen Gebäude erscheinen kann.

Einfach gesagt: KI nutzt nicht nur mehr Speicher als früher. Sie definiert neu, was eine normale Menge an Speicher überhaupt ist.

Wie dieser Artikel entstanden ist

Autorenbiografie unten — Spezialist für USB-Speichersysteme und Duplikation

Dieser Artikel wurde mit KI-Unterstützung für Gliederung und Formulierungen erstellt und anschließend von einem menschlichen Autor geprüft, überarbeitet und finalisiert, um Klarheit, Genauigkeit und Praxisbezug zu verbessern.

Bildhinweis

Das Bild am Anfang dieses Artikels wurde mithilfe künstlicher Intelligenz zu Illustrationszwecken erzeugt. Es handelt sich nicht um eine Fotografie realer Umgebungen.

Tags:KI-Infrastruktur, NAND-Flash, Rechenzentren, Speichermangel, SSD-Nachfrage